上海交通大學圖像通信與網絡工程研究所教授武筱林在過去的半年里收到過無數的批評郵件,不少媒體報道里也引述了一些專家學者的批評意見。但這次,三名美國研究者在網絡上撰寫洋洋灑灑的萬字長文向他隔空喊話,點名批評他的研究為“科學種族主義”。

這篇萬字長文名為《相面術的新外衣》(Physiognomy’s New Clothes),于當地時間5月6日發表在新媒體網站Medium上。三名作者,Blaise Ag徂era y Arcas是機器學習領域的著名工程師,2013年從微軟跳槽到谷歌;Margaret Mitchell同樣是谷歌的人工智能研究員;而Alexander Todorov則是普林斯頓大學的神經科學教授。

這一切都源于武筱林和其博士生張熙于去年11月上載在預印本網站arXiv上的一篇論文,題為《基于面部圖像的自動犯罪概率推斷》(Automated Inference on Criminality using Face Images)。

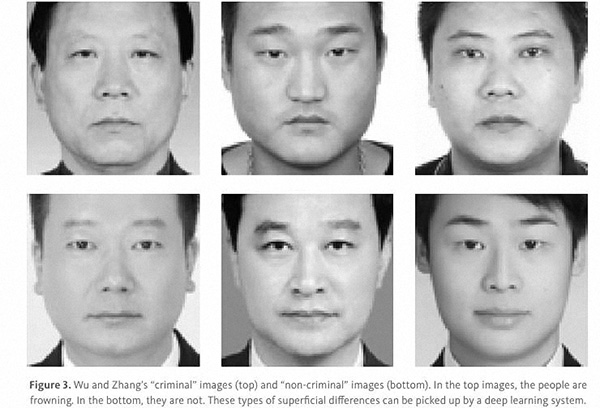

研究使用的照片樣本。a組為罪犯,b組為非罪犯。

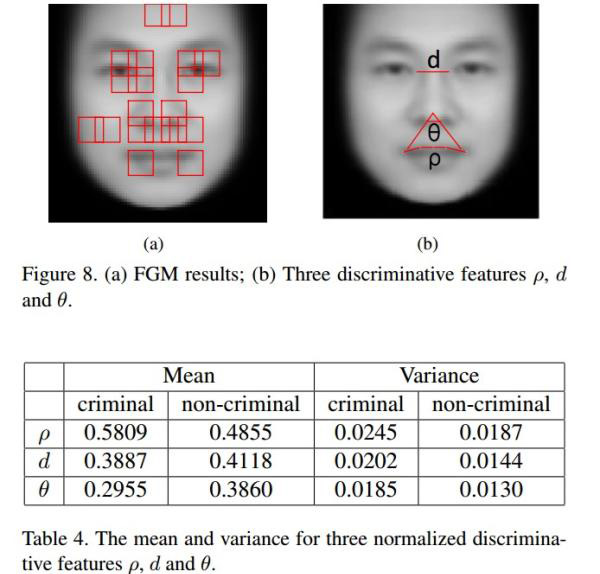

武筱林和張熙運用計算機視覺和機器學習技術檢測1856張中國成年男子面部照片,其中將近一半是已經定罪的罪犯。實驗結果顯示,通過機器學習,分類器可以以較高概率區分罪犯與非罪犯這兩個群體的照片。特別是在內眼角間距、上唇曲率和鼻唇角角度這三個測度上,罪犯和非罪犯存在較為顯著的差距。平均來講,罪犯的內眼角間距要比普通人短5.6%,上唇曲率大23.4%,鼻唇角角度小19.6%。同時,他們發現罪犯間的面部特徵差異要比非罪犯大。

平均來講,罪犯的內眼角間距要比普通人短5.6%,上唇曲率大23.4%,鼻唇角角度小19.6%。

三名美國學者在時隔半年後評價道:“隨著人工智能和機器學習的高速發展,我們迎來了科學種族主義的新時代。”他們聲明,寫作這篇深度文章,“不僅僅是為了研究者、工程師、記者和決策者,也是為了想要確保人工智能是有益于人類的每一個人。”

不過,武筱林此前在接受澎湃新聞(www.thepaper.cn)專訪時曾提過,他歡迎學術上的交流和討論,也歡迎用數據來質疑他的結論。至于政治倫理方面的問題,則需要更廣泛的社會討論,並非他個人所能解答的。

谷歌研究員的萬字長文雖然也提出了幾個可能造成武筱林實驗數據“假象”的技術問題,但其核心論點拋開了針對論文細節的討論,站在政治正確性的角度,從歷史、倫理出發,對相面術及其在機器學習時代的新形態進行了批評。

“機器相面術”,新瓶裝舊酒

三位美國學者的文章並非學術論文,在萬字的篇幅中,他們講述了相面術發展的歷史,解釋了機器學習研究領域的一些基本情況,並以武筱林和張熙的研究為靶子,指出就像他們的研究是披著機器學習外衣的相面術,人類社會中的許多歧視也可能會被算法洗白。

關于相面術的歷史,他們是從龍勃羅梭開始講起的。

1870年,意大利監獄醫生龍勃羅梭(Lombroso)打開了意大利著名土匪頭子維萊拉屍體的頭顱,發現其頭顱枕骨部位有一個明顯的凹陷處,它的位置如同低等動物一樣。這一發現觸發了他的靈感,他由此提出“天生犯罪人”理論,認為犯罪人在體格方面異于非犯罪人,可以通過卡鉗等儀器測量發現。龍勃羅梭並認為犯罪人是一種返祖現象,具有許多低級原始人的特性,可被遺傳。

龍勃羅梭的研究支持著他的政治主張:意大利南方人要比北方人更文明。此後,龍勃羅梭在“顱相學”和“天生犯罪人”方面的追隨者同樣將自己的研究與某些政治主張捆綁。塞繆爾 莫頓(Samuel Morton)推崇白人至上的顱骨學投射的是19世紀美國的白人奴隸主,而德國兒童教材《毒菌》(Der Giftpilz)上教授通過鼻子形狀辨別猶太人,則投射了納粹時代。

文章的三位作者指出,“相面術試圖從人的外貌推測其內在性格。雖然今天相面術被視為偽科學,但民間還是有人相信可以從面相或身材中鑒別出低級一點的人群。而在有些歷史時期,相面術也內嵌在了國家法律中,為侵佔土地、反移民、奴隸制和種族清洗提供依據。而關于相面術的偽科學就是科學種族主義。”

他們認為,上述的這類研究在人工智能時代的新形態就是武筱林式的。“在計算機和大數據無處不在的時代,‘機器相面’開發出了許多前所未有的用途。因此,人工智能的開發者、評論家、用戶們都急需了解技術的邊界和相面術的歷史,如今它披上了現代的外衣。”

機器習得了人類的偏見

文章最擔憂的問題,是人類社會的一些歧視和偏見,作為訓練模型嵌入機器學習後,就被“洗白”了。畢竟,算法的輸入和輸出看上去是非常公正客觀的。

武筱林和張熙在論文中寫道,“人類觀察者的主觀判斷會造成偏見,我們首次在排除人為偏見的情況下,探究基于臉部特徵自動推斷犯罪分子。”

文章的三位作者認為,無論是否借助機器學習的工具,相面術,即試圖通過外貌特徵預測行為性格,都基于以下三個有漏洞的隱藏假設:

1、一個人的外貌是由先天決定的;

2、“犯罪性”是某個特定群體的天生屬性;

3、司法係統中的刑事判決不受外貌的影響。

為此,文章對這三點假設一一作了駁斥。值得注意的是,武筱林在論文中並未提及這三點假設中的任何一點,他將實驗結果的解讀空間留給了社會科學領域的學者。

三位美國學者指出,首先,面部特徵不是完全天生的,成長、環境的影響也很大。此外,攝影時的環境也影響著照片上呈現的人臉。就像在武筱林在論文中提及的2011年康奈爾大學的心理學研究中,學者將罪犯的照片與在校園中拍攝到的人臉作為研究材料,就可能對研究結果造成幹擾。

其次,“犯罪階級”這個概念在19世紀十分流行。為此,英國將罪犯流放到了澳大利亞以減少英國的犯罪率。不過,事實證明,澳大利亞並沒有成為充斥著犯罪的地獄。此前,也有研究認為較高的睪酮水平會增加侵略性。然而,它們都無法取得很高的相關性。簡而言之,目前人類的研究只發現身體外觀與行為可能存在微弱相關。

最後,文章提到,在美國,一名黑人男性被監禁的可能性是白人男性的7倍。而犯有同樣罪行的黑人罪犯往往會遭受更重的刑罰。因此,研究中所用的罪犯數據可能就是法官偏見的結果。

換言之,武筱林和張熙的實驗並不是找到了準確斷案的捷徑,而是揭示了人類判斷、包括官方刑事判決中的不準確和係統性的不公正。

捅破了窗戶紙

文章提到,學術界很多人都覺得武筱林和張熙的研究在倫理性和科學性上都很有問題。雖然三位作者也在文中指出了一些技術上可能的漏洞,比如不足2000個樣本很容易造成機器過度學習,以及機器學習到的可能只是照片上的表情(比如罪犯的照片更多地皺眉,而普通人的照片更多地微笑),但他們更強調研究的倫理性問題。機器學習是一種對普通人而言“強大而神秘的工具”,而武張的研究賦予某些“陳詞濫調”新的可信度。

文章總結道:“在科學層面上,機器學習是一個前所未有的窗口,可以窺見自然和人類行為,可以讓我們反思及係統地分析所謂的直覺和群體智慧。武筱林和張熙的研究結果與此前的一些研究一樣捅破了一層窗戶紙,揭示了我們究竟是如何鑒別別人的。

在實踐中,機器學習技術會越來越多地介入人類生活,就像許多強有力的工具一樣,它們通常會幫助我們,包括更快更客觀地分析數據。

但機器學習也可能會誤用,這種誤用常常是無意的。過分狹隘地局限在技術問題上就可能導致這種誤用,比如:

沒有洞見訓練數據來源中的偏見;

沒有仔細審查該領域的現有研究,尤其是機器學習領域之外的;

沒有考慮可能導致測得相關性的多種因果關係;

沒有充分考慮這種機器學習係統的應用場景和其社會影響。

武筱林和張熙的論文充分展示了上述陷阱。非常不幸,他們測得的相關性又揭示了刑事判決中普遍存在的偏見,該領域的研究已經頗為矚目,如今又添磚加瓦。基于面部特徵的深度學習絕不該應用為‘加速’司法公正的工具,如果真的這麼做的話,反而會讓不公正長存于世。”

武筱林:“核物理學家該為原子彈造成的傷害負責嗎?”

文章還預計,近期會有類似的研究出現,“它們抱有同樣的偏見、短視,並宣稱自己是科學客觀的,以此來‘洗白’人類的偏見和歧視。”文章還點名批評了一家以色列初創企業Faception,其致力于運用人臉分析識別恐怖分子、戀童癖和白領罪犯。

對此,武筱林曾向澎湃新聞(www.thepaper.cn)透露,國際上確實有一些同行在做類似的研究,他就是為了搶佔研究的優先權,才在arXiv上傳了論文。

去年11月底,正處于第一波輿論漩渦的武筱林曾接受澎湃新聞(www.thepaper.cn)的專訪,並回應過許多核心質疑。

首先,武筱林表示歡迎技術上的交流,他也受到過許多有價值的反饋。比如,他們的樣本量確實可能過小。此外,也有人指出過他們樣本中的罪犯和守法公民可能更多代表了經濟地位上的差異。他們也曾採納一些反饋而做出調整。有人指出警察拍攝犯人照片的相機可能有特定的參數,他們就在照片中添加了許多噪點以削弱其影響。

其次,武筱林強調他從未有任何應用方面的意圖。就算有別人想要把這個研究用于實踐,考慮到中國社會千分之幾的犯罪背景概率,研究中80%以上的真陽性概率放在現實中的準確性也很低。

第三,武筱林強調他個人是反歧視的。甚至,一開始他們做這個研究的目的,就是看了龍勃羅梭的研究和2011年康奈爾大學的心理學實驗(實驗發現人光靠照片鑒別罪犯的成功率非常高)後,出于好奇想要證偽,結果卻令他們大吃一驚。

對于令學界和輿論界“炸鍋”的實驗結果,武筱林強調他只呈現了其中的相關性,而其中的因果關係,即到底是長相決定了天生的犯罪性,或者是人類社會對長相的歧視促成了犯罪概率的差異,則留待社會科學的解讀。

至于這個研究一開始到底該不該做、做完後該不該公布,這同樣屬于社會科學討論的范疇,武筱林坦言他難以回答。“為了人類社會更高的利益,是不是科學家要自律一點,而不是說求知求真者無罪,這個爭議在世界范圍內已經開始了,人工智能已經到這一步了。是不是就會有一些禁區,研究者不能去碰它,坦白講我不知道。”

“核物理學家該為原子彈造成的傷害負責嗎?”這是武筱林拋回給澎湃新聞的疑問。

[責任編輯:郭曉康]